2022年6月1日至9月18日,由MIT、CMU、PSU等八家国际知名学府与FaceBook等企业联合发起的“Ego4D”挑战赛于线上举行。浙江大学网络空间安全学院与美国微软研究院共同组成EgoMotion-COMPASS战队,在“临界帧时序定位”赛道与“物体状态改变预测”赛道上均荣获第二名。

一、赛事介绍

“Ego4D”挑战赛基于包含700多人的日常生活,总计达2200多小时的第一人称视频数据集——Ego4D,提出了情景记忆、行为预测、视听分类、场景理解、社交交互共五类挑战;致力于推动人工智能在第一人称视角感知与理解领域的进步,解决机器人控制、增强现实、3D场景建模、多模态信息融合等多个领域在现实场景中的问题。

本次比赛涵盖了基于视觉、语言的情景查询,临界帧时序定位,物体状态改变预测,说话人预测与视觉定位,长、短期行为预测等16个比赛赛道,吸引了来自威斯康星大学、布朗大学、新加坡国立大学、香港中文大学、香港城市大学、清华大学、北京大学、南京大学、东京大学、Shanghai AI Lab、Microsoft Research、Intel Lab、Meta AI、Google Research等高校与研究院共百余支实力强劲的队伍参加。EgoMotion-COMPASS战队在本次挑战赛中参加了“临界帧时序定位”和“物体状态改变预测”两条赛道,并且均荣获第二名。

图一:Ego4D Workshop @ ECCV 2022 在线会议:临界帧时序定位赛道获奖信息公布。

图二:Ego4D Workshop @ ECCV 2022 在线会议:物体状态改变预测赛道获奖信息公布。

二、赛道内容与方法简介

第一人称视频学习(Egocentric video learning)是当前自监督视频学习(self-supervised video learning)领域的研究热点,其成果能够应用于多个领域并解决存在的实际问题。然而,由于此前在第一人称视频理解领域缺乏足够规模的数据集,学术界在该领域的研究仍然处于实验探索阶段,提出的众多方法在实际场景下缺乏足够的有效性与泛化性。

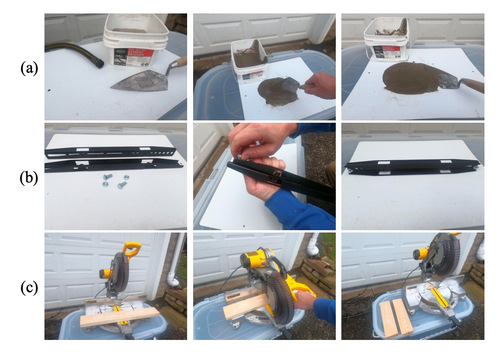

临界帧时序定位(PNR Temporal Localization)与物体状态改变预测(Object State Change Classification)两个赛道都基于“状态改变”这一概念,侧重于验证方法从人的角度出发对视频内容的理解能力。其中,“物体状态改变预测”任务旨在对第一人称视频中出现的物体状态是否发生改变进行分类预测;而“临界帧时序定位”任务旨在判断给定一段包含物体状态改变的第一人称视频中状态改变发生的时刻。

图三:“状态改变”示例 (a) 工程作业 (b) 组装零件 (c) 切割木板

EgoMotion-COMPASS战队使用基于Predictive Learning的无监督预训练方法,并充分利用第一人称视频中存在的丰富的时序信息与人的动作信息,在经过反复的实验验证与不断改进之后,最终在物体状态改变预测赛道达到了78%的预测准确率,在临界帧时序定位赛道达到了低至0.65s的平均时序定位误差。

三、结语

在本次比赛中,指导老师与参赛同学对赛道任务进行了深入的分析,并共同探讨了相关领域中的各类方法以及方法各自实际效果,确定了最终的方案与可能的改进方向。通过对方法的不断打磨与改进,EgoMotion-COMPASS战队最终在Ego4d挑战赛两个赛道均荣获第二名。再次向获奖的老师与同学表示祝贺!希望今后同学们可以再接再厉、再创佳绩!